Les Fake News, ou articles colportant de fausses informations pour de nombrueses raisons dont la désinformation, ont défrayé la chronique depuis quelques mois et notamment les dernières élections américaines. Les grands moteurs (Google) et réseaux sociaux (Facebook) peinent aujourd’hui encore à trouver des solutions algorithmiques contre ce fléau. L’humain restera-t-il le seul rempart pour lutter contre ces tentatives, et ce pour quelques années encore ?

Par Philippe Yonnet

Par Philippe YonnetGoogle et Facebook sont depuis des mois sur la sellette, accusés d’avoir contribué de manière massive à la diffusion d’informations erronées, les fameuses « fake news ». La diffusion de fausses nouvelles n’est pas une pratique récente, loin s’en faut. L’histoire est remplie de tentatives de manipulation des opinions par la diffusion d’informations trompeuses ou de propagande. Si le néologisme « fake news » a été inventé et si le phénomène a autant d’écho aujourd’hui, c’est parce que la diffusion de fausses nouvelles a été facilitée par Internet, les moteurs de recherche et par l’explosion des réseaux sociaux, et parce que certains groupes se sont engouffrés dans les failles de ce nouveau contexte et les exploitent à présent de façon industrielle.

Le problème, nous allons le voir, est que Facebook ou Google vont cette fois-ci avoir du mal à répondre à ce nouveau défi en inventant de nouveaux algorithmes. Pour une fois, c’est un problème posé à tout l’écosystème qui produit, filtre et diffuse l’information. Google, dont la devise initiale était de « mettre de l’ordre dans l’information » a cette fois-ci besoin qu’on l’aide à le faire efficacement.

Les différents types de « fake news »

Sous le vocable « fake news », on regroupe des contenus parfois très différents. La motivation de leurs auteurs en particulier peut être variée.

Le contenu fabriqué « ad hoc »

C’est évidemment le type de « fake news » le plus critiqué. Il s’agit de contenus conçus pour tromper le lecteur, avec un objectif clair de manipulation. Les auteurs de ces contenus savent pertinemment que les informations diffusées sont fausses.

Le contenu détourné

Plus subtil, il reprend des informations authentiques, mais l’auteur glisse quelque chose de manipulé au sein d’un texte ou d’une image par ailleurs véridique. Ce type de fake news est insidieux, car la tromperie n’est pas toujours détectée par les observateurs, même bien informés.

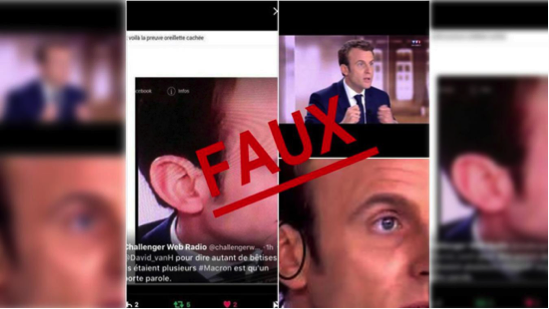

Fig. 1. L’affaire de l’oreillette d’Emmanuel Macron est un bon exemple de contenu détourné : la photo originale a été légèrement retouchée pour laisser penser que le candidat portait une oreillette. A basse résolution, impossible de distinguer les photos authentiques des fausses. Mais en zoomant sur les photos originales, la vérité apparait : aucune oreillette n’est visible dans le pavillon du candidat

Phlippe Yonnet

Directeur Général de l’agence Search-Foresight, groupe My Media (http://www.search-foresight.com)