Créé en 2012, Botify est un outil en mode SAAS qui a pour vocation d’accompagner au quotidien les SEO managers dans leurs chantiers d’analyse et d’optimisation. Botify permet d’analyser un site web, d’identifier des possibilités de croissance et de monitorer le comportement des moteurs de recherche. Présentation de l’outil et de ses fonctionnalités.

Par Jean-Benoît Moingt

Par Jean-Benoît MoingtLa société Botify a développé l’outil Botify Analytics (que nous appellerons « BA »), un crawler qui parcourt l’intégralité de votre site comme le font les robots d’indexation des moteurs de recherche. Pendant le crawl, BA collecte des centaines d’indicateurs sur chacune des pages qu’il découvre.

Une fois analysées, ces millions de données font l’objet d’un rapport permettant d’identifier des points de blocage et des projets d’optimisation. Toutes ces informations sont disponibles avec une vision globale, une vision par segment (vous pouvez « découper » votre site par templates de pages mais aussi par logique métier : catégories de produits, marques, gammes tarifaires, …) et à la maille URL.

Fig. 1. Le rapport généré par BA propose des centaines d’indicateurs.

Les aspects techniques

Premier « pilier » du référencement, la bonne construction technique du site web est fondamentale si l’on souhaite qu’il soit correctement pris en compte par les moteurs de recherche.

Un site mal conçu techniquement est l’assurance d’un mauvais référencement ! Botify va entre autres mesurer :

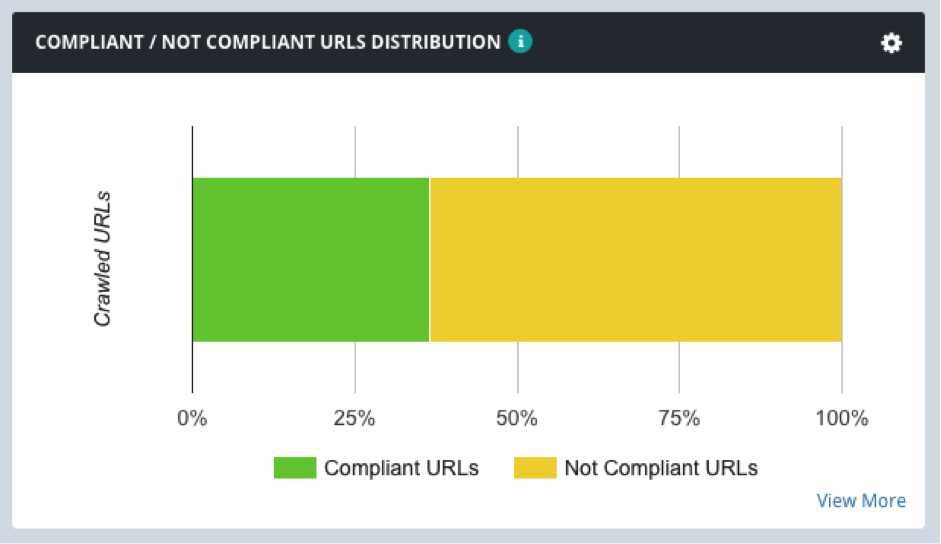

• Les pages non conformes (« not compliant ») : pages non indexables par un moteur de pages (à cause d’un mauvais code HTTP, d’une balise noindex, d’une balise canonical vers une autre page, …). Sur certains sites, nous découvrons plus de pages « not compliant » que de pages « compliant » ! Ce n’est jamais bon signe quant à l’état de santé du site.

Fig. 2. Ce site a 65% de pages Not Compliant ! Nettoyage de printemps en perspective !

• La présence des balises : Title, H1, description, etc. Ces balises sont des fondamentaux du SEO. Botify Analytics va vérifier sur chaque page la présence de ces balises mais également contrôler leur unicité.

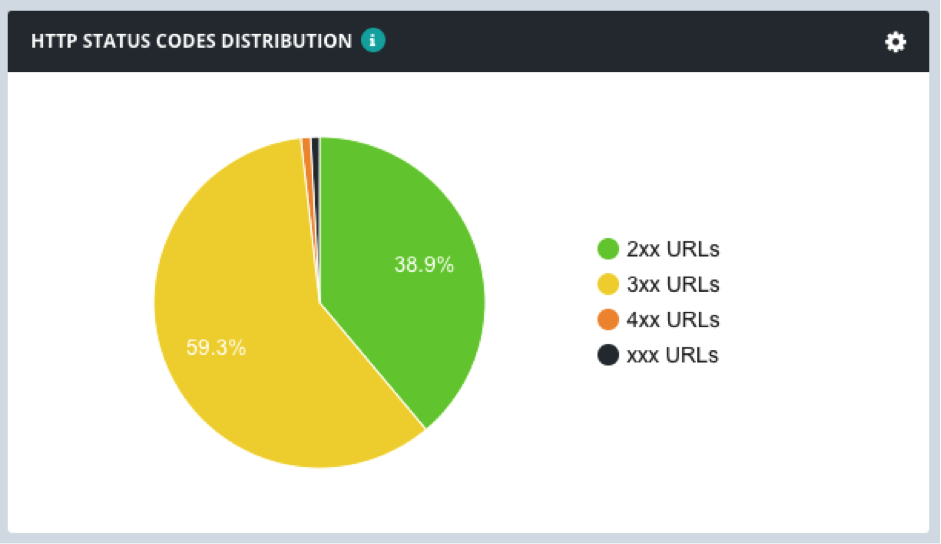

• Les codes HTTP : retournés par le serveur, ces codes permettent d’indiquer au client le statut de la requête. 200 signifie « OK », les codes 3xx concernent les redirections, les codes 4xx les erreurs… En toute logique, un site doit avoir une majorité de codes 200, mais c’est loin d’être toujours le cas.

Fig. 3. Une grande partie des pages de ce site est en 301, les changements d’URLs n’ont pas été bien gérés.

• Les performances : il n’est plus nécessaire de démontrer la corrélation entre la vitesse de chargement de vos pages et le nombre d’entre elles que va crawler Googlebot quotidiennement. Le rapport va mettre en évidence les segments les moins performants qui mériteront une optimisation.

La qualité du contenu

Deuxième « pilier » du référencement, le contenu est devenu critique depuis que l’algorithme Google Panda a commencé à sanctionner les contenus de mauvaise qualité en 2011.

Comment évaluer la qualité de son contenu sur des sites qui font plusieurs milliers, voire millions de pages ? Botify essaie d’y apporter des réponses à travers des algorithmes d’analyse.

Premier indicateur : BA va compter le nombre de mots présents sur chacune de vos pages en excluant le template (header, menus, footer, …). Il y a fort à parier qu’un site constitué à 98% de contenu « template » et qui a moins de 100 mots de contenu véritable en moyenne par page ne soit pas très bien perçu par Google.

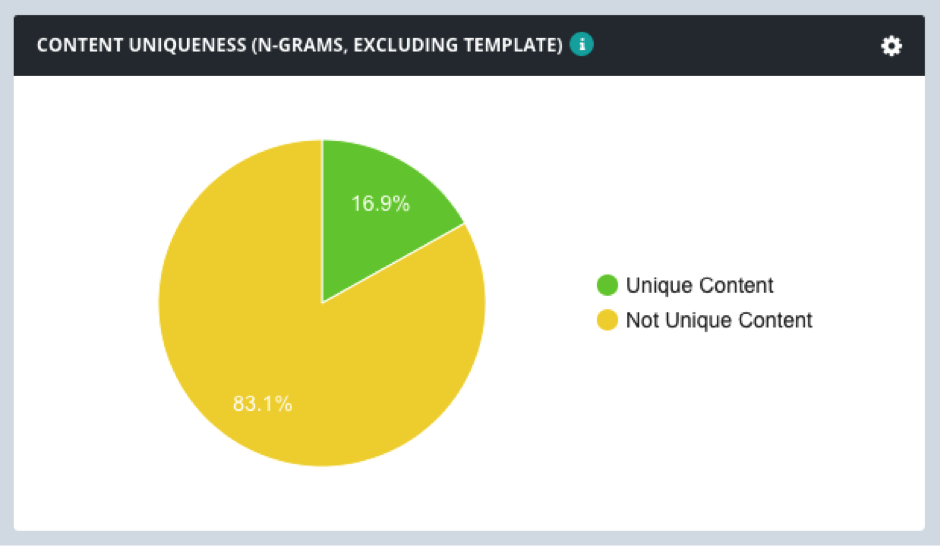

Botify va également mesurer la similarité de vos contenus internes. Vous pourrez ainsi identifier les pages dupliquées qu’il faudra corriger rapidement mais également celles en near duplicate à optimiser.

Fig. 4. L’unicité du contenu laisse à désirer sur ce site.

Grâce à l’URL Explorer, vous pourrez faire des recherches avancées du type : « Quelles sont les URLs contenant moins de 100 mots, dupliquées à plus de 80% et qui ne font pas de trafic ? ». Bien pratique pour entamer un chantier de nettoyage ou d’amélioration des contenus…

Le maillage interne

Composante essentielle de l’optimisation SEO d’un site, le maillage interne consiste à rendre accessible votre inventaire de contenu aux robots d’indexation. En simplifiant, on peut dire que les Googlebot, Bingbot, Slurp, YandexBot et autres Baiduspider partent de votre page d’accueil et découvrent vos contenus en suivant les liens disponibles. C’est exactement ce que va faire Botify Analytics en collectant au passage toutes les données disponibles. Sur certains sites, cela peut représenter plusieurs centaines de millions de liens !

Jean-Benoît Moingt

Search Data Strategist, Botify (https://www.botify.com/)