Le marché des assistants vocaux ne cesse de progresser année après année et promet une révolution des usages à venir. S’il est encore intéressant de comparer les chiffres d’utilisation selon les supports (les assistants vocaux étant principalement utilisés sur smartphone à ce jour), nul ne peut ignorer la multiplication des ventes des enceintes connectées à assistance vocale. Les diverses études menées semblent toutes indiquer que les recherches vocales vont devenir courantes après 2020. Il est donc temps de se préparer à changement pour lequel le géant Amazon est en première ligne avec Alexa et ses « skills ». Cet article va vous expliquer, pas à pas, comment créer votre première skill. Bonne chance !

Par Mathieu Chartier

Par Mathieu ChartierNous avions évoqué dans une précédente lettre (février 2018) les « actions » de Google Home, pour mettre en lumière les applications vocales chères aux assistants vocaux. Ce mois-ci, nous allons nous intéresser à la technologie Echo d’Amazon, le principal concurrent de Google, aux chiffres plus que flatteurs. Si les chatbots vous ont fait peur, peut-être que les skills d’Amazon vont vous séduire au point de concevoir des vocalbots de qualité…

Le marché des assistants vocaux en plein essor

Quand il s’agit d’évoquer le marché des assistants vocaux, toutes sortes de chiffres sortent d’études diverses et variées, et il est parfois difficile de trouver le vrai et le faux dans tout cela. Une tendance générale semble toutefois se dégager début 2019, mais il convient de ne pas se tromper de chiffres. En effet, d’une part les constructeurs vantent leurs chiffres d’utilisation et d’autres part, le marché montre quelques différences entre ces usages et la réalité. Voyons cela un peu plus en détail.

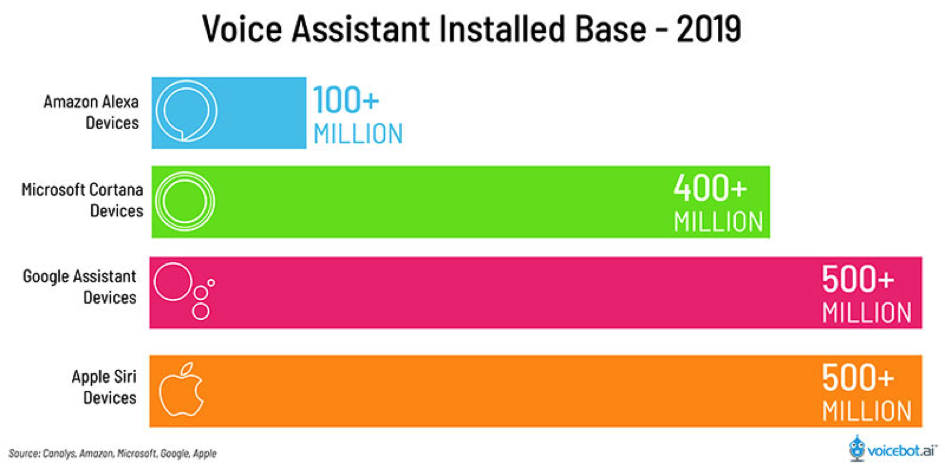

Il faut tout d’abord parler de la présence des technologies vocales chez les utilisateurs. Sur ce point, des marques comme Apple n’hésitent pas à bomber le torse pour montrer à quel point Siri est présent sur le marché des assistants vocaux. C’est certes vrai, tant les iPhone sont présents dans le monde, mais on ne peut pas dire que l’Homepod d’Apple soit en revanche un franc succès à ce jour avec seulement 6% de parts de marché aux Etats-Unis par exemple, contre 24% pour Google Home et presque tout le reste pour Amazon Echo, soit près de 70% (source : https://cnb.cx/2Dq3Jka). Il faut donc bien distinguer le nombre de fois où la technologie est disponible (avec un fort avantage pour les marques possédant des OS pour mobile) et les parts de marché.

Sur le plan des installations, il convient de mesurer le potentiel d’un assistant vocal, et non pas son réel succès ou son adoption auprès des utilisateurs. Apple Siri domine outrageusement le nombre d’appareils dotés d’un assistant avec Google, chacun ayant plus de 500 millions d’installations connues début 2019 selon VoiceBot (voir figure 1). Microsoft Cortana est également très présent grâce à l’essor de Windows 10 et Windows 10 Mobile, là où Amazon atteint les 100 millions d’installations uniquement avec ses enceintes connectées. Comme le disait Einstein : « tout est relatif ». Et c’est d’autant plus vrai quand on manipule des chiffres.

Fig. 1. Nombre d’installations des assistants vocaux.

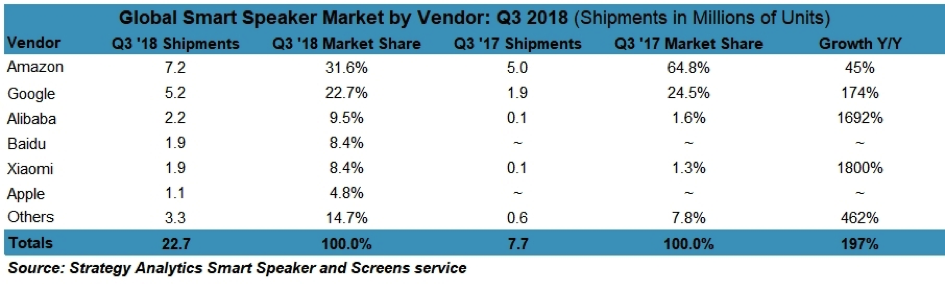

Concernant les parts de marché réelles, basées sur les usages, on peut remarquer que la hiérarchie est bouleversée. Selon une étude approfondie de la société Strategy Analytics pour le 3e trimestre 2018 (source : http://bit.ly/2DriG5A), Amazon est encore leader du marché sur le vocal, devant Google (Apple étant le dernier des principaux leaders dans ce classement).

Fig. 2. Parts de marché des assistants vocaux par marque.

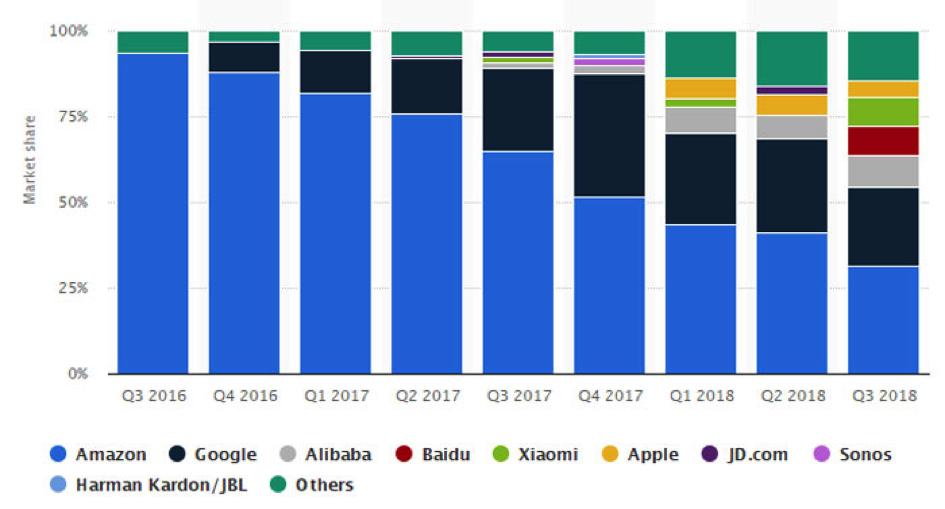

En revanche, le constat est sans équivoque : Amazon perd peu-à-peu des parts de marché, tant les acteurs se multiplient et répartissent les usages. Il sera intéressant de voir à l’horizon 2020 la hiérarchie revue et corrigée après que les utilisateurs aient fait leur choix en termes d’assistants vocaux. Les chiffres de Statista montre bien la courbe de croissance du marché depuis quelques années (source : http://bit.ly/2BtH9qP).

Fig. 3. Évolution du marché des assistants vocaux (2016-2018).

Il est difficile d’obtenir des études aussi précises en France et c’est pourquoi nous nous basons essentiellement sur les données mondiales, bien que les Etats-Unis soient clairement dominants dans ces mesures.

Et le SEO vocal dans tout ça ?

On parle fréquemment d’AEO en matière de SEO vocal. Entendez par là la nouvelle discipline de l’Answer Engine Optimisation, à savoir l’optimisation pour les moteurs de réponses en quelque sorte. L’idée est donc un peu plus large que celle d’un simple SEO vocal tel que nous le décrivons depuis des mois.

Si nous observons de près les SERP de Google par exemple, nous remarquons que rien n’est réellement vocal à ce jour. En revanche, le moteur de recherche va s’imprégner des résultats proposés, et notamment de ses « Positions 0 » pour répondre aux utilisateurs de Google Home ou de l’assistant vocal sur Android. On pourrait parler ici de SEO vocal, mais le concept d’AEO est plus réaliste, car il s’agit en effet de trouver des moyens de fournir des réponses toutes faites à Google, pour nourrir les assistants vocaux.

Mathieu Chartier

Consultant-Formateur et webmaster indépendant, Internet-Formation (https://www.internet-formation.fr)

5

5