Comme n’importe quel site web ou outil sur la Toile, Google utilise des serveurs, des ordinateurs et donc des adresse IP. Il existe un certain nombre de façons de les récupérer pour s’en servir en SEO, à des fins d’analyse de logs ou de veille, voire d’alertes sur certains positionnements. Cet article a pour vocation de vous expliquer comment gérer et utiliser ces plages d’adresses IP, correspondant aux spiders ou aux datacenters de la firme de Mountain View, dans votre quotidien de référenceur.

Par Daniel Roch

Par Daniel RochComme n’importe quel outil en ligne et n’importe quel crawler, Google a ses propres adresses IP. Dans cet article, nous allons voir comment les récupérer et comment les utiliser en référencement naturel.

C’est quoi un data center ?

Avant tout, commençons par quelques explications : un centre de données (« datacenter » en anglais) est un lieu où une entreprise va stocker l’ensemble de son système d’information : ses données, ses outils, etc.

Chez Google, l’entrrepise va ainsi stocker ses différents sites et applications (le moteur de recherche, ses outils en ligne, etc.) mais surtout toutes ses données, notamment la liste de toutes les URL indexées dans le monde entier et les informations qui vont avec.

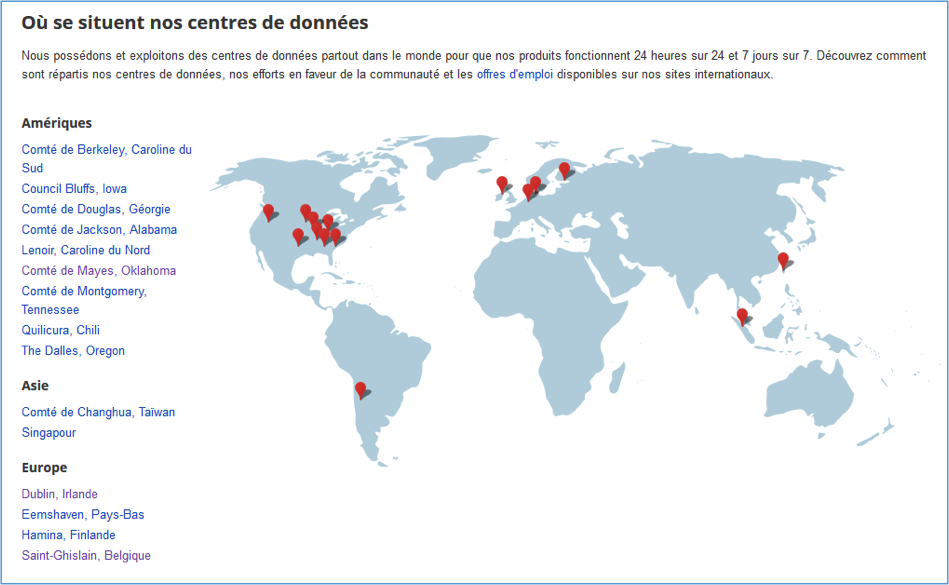

Google a ainsi déployé différents centre de données dans le monde, chacun contenant les serveurs nécessaires aux différents outils de Google (le moteur de recherche, Google StreetView, Google Doc, etc.).

Les data center de Google. Source : Google.

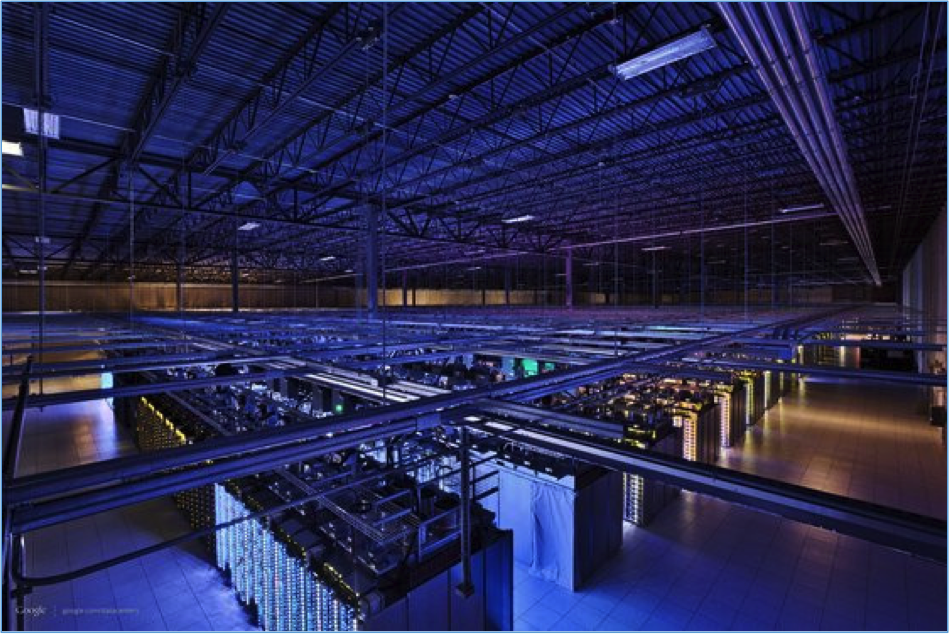

En 2011, Google avait déjà à sa disposition plus de 900 000 serveurs (source). Et pour traiter et stocker l’intégralité des informations dont il a besoin, chaque Data Center de Google abrite des centaines de serveurs, comme le montre cette seconde image :

Un exemple de serveurs chez Google..

Les IP de Google

Lorsque vous allez vous connecter à un serveur de Google, par exemple lors d’une recherche, vous allez utiliser l’adresse IP de Google. De même, quand Google viendra parcourir votre site, son robot GoogleBot aura également une adresse IP spécifique.

Daniel Roch, consultant WordPress, Référencement et Webmarketing chez SeoMix (http://www.seomix.fr)

5