À notre époque emplie de « fake news », il est parfois difficile de séparer le bon grain de l’ivraie et de se faire une idée de la qualité et de la fiabilité d’une source d’information trouvée dans le monde numérique en général et sur le Web ou les réseaux sociaux, en particulier. Il nous a semblé intéressant de mettre à plat un certain nombre de concepts et d’essayer de comprendre, dans cette série d’articles, comment avancer, d’une manière la plus « scientifique » possible, dans notre approche de l’information et des sources qui la diffusent…

Par Christophe Deschamps

Par Christophe Deschamps

En 2016, l’Oxford Dictionary décidait de déclarer le mot « post-vérité » (post-truth) mot de l’année. Il faut dire qu’entre les « bulles de filtre » accusées d’avoir aidé à l’élection de Donald Trump et la déclaration de son porte-parole, Sean Spicer, indiquant que « parfois nous pouvons être en désaccord avec les faits », l’année avait été particulièrement mortifère pour la notion de vérité.

Bien sûr la désinformation ou la mésinformation sont vieilles comme le monde et participent depuis toujours des stratégies d’influence mises en œuvre par les organisations comme par les individus, pour faire avancer leurs idées, mais la puissance et l’emprise des réseaux sociaux ont donné à ces contenus une capacité de propagation et éventuellement de manipulation, totalement inédites dans l’histoire de l’humanité. Notre capacité à détecter ces influences pour les contrer, les combattre ou tout simplement en tenir compte dans nos raisonnements est donc devenue essentielle au renforcement de notre esprit critique et cette série d’articles se propose de donner quelques clés permettant à tout un chacun d’effectuer ce travail critique.

Les grands types de risques informationnels

D’après l’organisation d’aide aux journalistes pour la vérification d’informations provenant des réseaux sociaux Firstdraftnews (https://firstdraftnews.org/), il existe au moins sept types de mésinformation/désinformation. Commençons par définir ces deux mots :

- Désinformation : processus aboutissant à l’intégration, par un public, d’informations distordues, incomplètes ou fausses (avec des conséquences éventuelles sur certaines de ses décisions futures), ces altérations trouvant leur origine dans une démarche volontaire, avec pour objectif de tromper.

- Mésinformation : processus par lequel s’élabore et se diffuse une information distordue ou incomplète, du fait du manque de vigilance, d’un excès de confiance, de l’indolence, du manque de méthode, de l’ensemble des maillons de la chaîne d’information.

(Source : Florian Gouthière http://curiologie.fr/2015/11/mesinformation-ou-desinformation/)

Les sept types évoqués plus haut sont :

-

- Les contenus satiriques ou parodiques qui peuvent parfois être relayés de manière sérieuse. Ainsi plusieurs politiciens français ont, par manque de vigilance, rediffusés des articles du site Le Gorafi en pensant qu’il s’agissait d’informations véridiques (cf. https://www.lemonde.fr/m-moyen-format/article/2017/05/05/quand-le-gorafi-est-pris-au-pied-de-la-lettre_5122943_4497271.html).

- Les titres ou photos d’illustration trompeurs : il s’agit de ces éléments accrocheurs qui ne sont pas en cohérence avec le contenu mais attirent le lecteur. Ce qu’on appelle en anglais « clickbait » ou, en français : « piège à clics » ou encore… « putaclics ».

- Sources contrefaites : il s’agit ici de tromper le lecteur en lui proposant des contenus sur une source ressemblant à l’original (charte graphique, logo,…). Ce type de manipulation est souvent utilisée par les hackers pour récupérer des mots de passe ou des numéros de carte de crédit mais peut aussi être mis en œuvre dans le simple but de tromper les lecteurs.

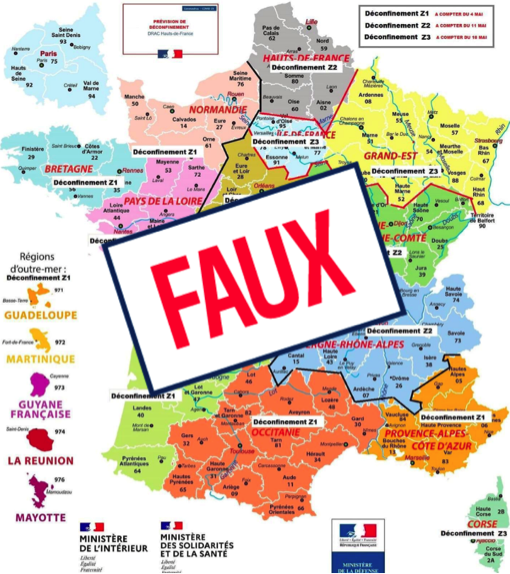

Fig. 1. Fausse carte de déconfinement reprenant les codes graphiques d’un document officiel..

-

- Faux contexte : utilisation d’une photo réelle en dehors de son contexte pour tromper le lecteur. Par exemple la photo ci-dessous montre la Seine charrier des déchets du fait de la crue de janvier 2018 mais illustre le numéro de Marianne consacré à la propreté de Paris en… mai 2019.

Fig. 2. Exemple de faux contexte sur une couverture de Marianne..

-

- Fausse interprétation : il s’agit de poser un faux discours, volontairement ou par manque de connaissance, sur une photo, un graphique, une carte géographique, … Les exemples de ce type ont été nombreux avec le COVID19, l’un des plus marquants étant l’erreur d’interprétation de Philippe Douste-Blazy face à l’étude du Lancet sur l’efficacité de la chloroquine, étude elle-même jugée erronée depuis, ce qui ne rend pas raison pour autant à l’ex-ministre de la santé et médecin…

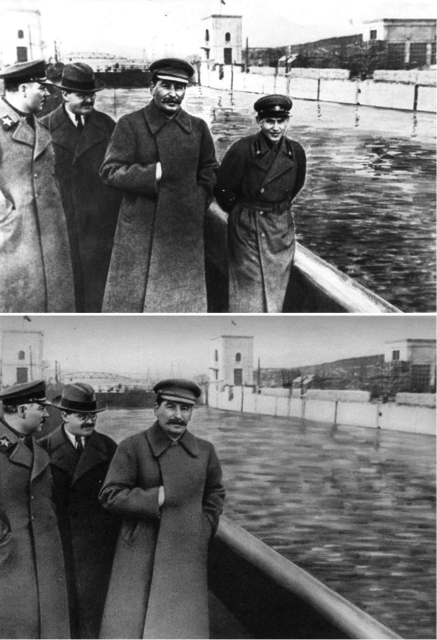

- Contenu manipulé : il s’agit de manipuler un document textuel ou iconographique dans le but de tromper le lecteur. Images « photoshoppées », texte originaux modifiés, tout est bon.

Fig. 3. Effacement de Nicolaï Iejov, superviseur des purges staliniennes, après sa disgrace auprès de Staline.

- Contenu fabriqué : l’idée est ici de créer un contenu textuel, iconographique ou vidéo totalement original. Les deepfakes, des vidéos créées à partir d’algorithmes de deep learning, dont le contenu peut faire dire n’importe quoi à des personnes connues (ou non) de manière très crédible en est l’exemple le plus récent et le plus inquiétant (voir l’exemple de ce vrai-faux discours de Barack Obama : https://www.youtube.com/watch?v=cQ54GDm1eL0).

Tout d’abord lutter contre nous-mêmes

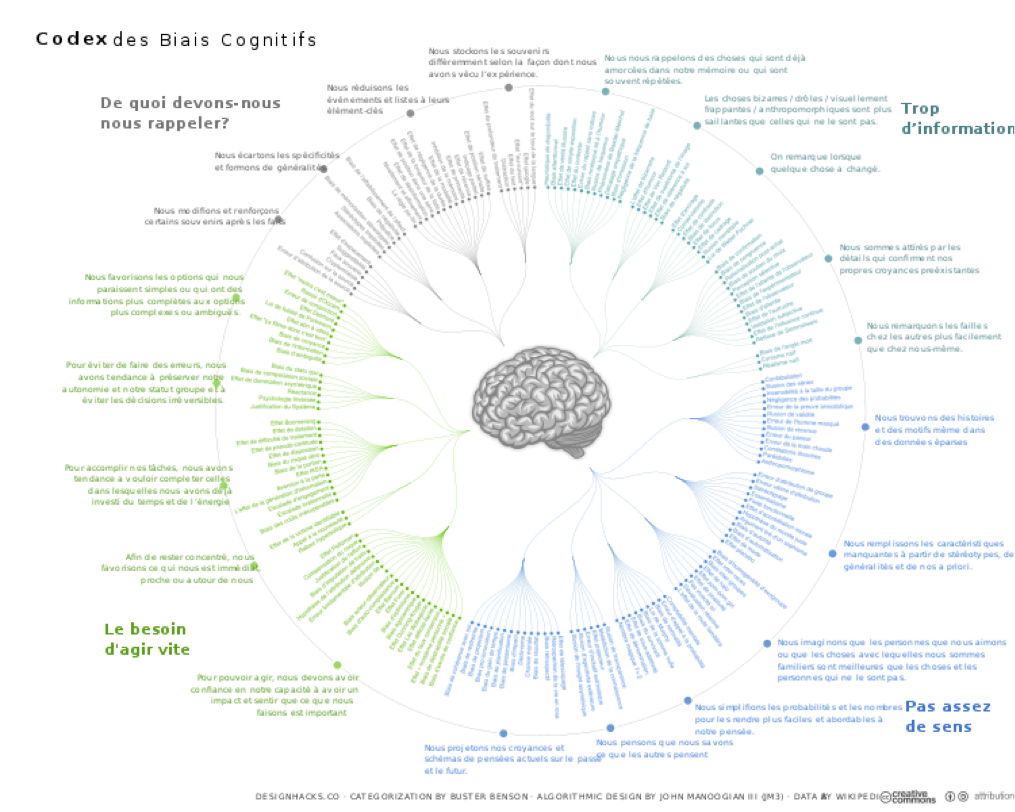

Nous avons découvert avec les travaux des psychologues Daniel Kahneman et Amos Tversky au début des années 1970 la notion de biais cognitifs. Il s’agit de modes de pensée que nous utilisons tous par défaut et qui mettent en œuvre de manière systématique des distorsions dans le traitement de l’information que nous recevons. Notre cerveau va faire des raccourcis pour parvenir le plus rapidement possible à une analyse de la situation qui soit cohérente avec notre vision du monde, vision elle-même forgée par notre éducation, notre milieu social et familial, notre culture, nos habitudes… Les biais cognitifs conduisent alors inévitablement à des erreurs de perception, de raisonnements, d’évaluation, d’interprétation logique, de jugement, d’attention ou à des comportements et des décisions inadaptés. On a ainsi pu identifier des dizaines de types de biais cognitifs :

Fig. 4. Codex des biais cognitifs.

On peut toutefois se concentrer sur les quatre principaux :

• Le biais d’ancrage : il désigne la difficulté que l’on rencontre à se départir de sa première impression. En se focalisant sur une première information, une première valeur ou un premier élément, l’esprit n’arrive plus à apprécier et prendre en considération les nouvelles informations, les nouvelles valeurs ou à envisager d’autres choix. Dans les débats publics, « l’effet d’ancrage » donne une prime aux personnes qui ont la capacité de prise de parole publique (expert, militant, journaliste, contestataire contre les institutions…), plus encore si leur point de vue est argumenté et que ceux qui les écoutent n’ont qu’une vague opinion sur le sujet. (Définition proposée par : http://www.toupie.org/Biais/Biais_ancrage.htm).

• Le biais de confirmation : c’est la tendance naturelle que nous avons à privilégier les informations qui confortent nos préjugés, idées reçues, convictions, hypothèses. Il consiste à accorder plus de poids aux preuves qui confirment les croyances initiales. Il contribue donc à un excès de confiance dans celles-ci et à les renforcer, même devant des preuves qui les infirment. Concrètement, on peut avoir tendance à rechercher des preuves compatibles avec l’hypothèse que l’on a accepté.

• L’illusion de savoir : il s’agit d’un biais de jugement conduisant un individu, face à une situation en apparence identique à une situation commune, à réagir de façon habituelle, sans éprouver le besoin de rechercher les informations complémentaires qui auraient pu mettre en évidence une différence par rapport à la situation commune. Ce biais « alimente » les croyances dans lesquelles nous sommes enfermés et nous empêche de tenir compte des événements nouveaux qui pourraient les contredire.

• L’effet de halo : c’est la tendance à rendre plus positives (ou plus négatives) certaines caractéristiques d’une personne, d’un groupe, d’une marque, etc., même si on ne les connaît pas, ou bien sans vérification, à partir d’une de ses caractéristiques que l’on avait préalablement jugée positive (ou, inversement, négative). Cela nous conduit à avoir une opinion négative d’une personne, du seul fait de son appartenance à un groupe que nous n’estimons pas ou inversement, à avoir une mauvaise opinion d’un groupe uniquement parce qu’une personne que nous n’apprécions pas en fait partie (définition proposée par : http://www.toupie.org/Biais/Effet_halo.htm).

Bien sûr ces biais peuvent être considérés comme autant de défauts qui peuvent nous induire en erreur. Mais on aurait tort de vouloir s’en débarrasser à tout prix (ce qui est de toutes façons impossible), en effet, ils ne sont pas constitutifs de nos modes de raisonnement par hasard et nous permettent en fait d’agir au quotidien en nous aidant à :

- Filtrer le trop grand nombre d’informations provenant de nos sens et sélectionner celles qui nécessitent une réaction (par exemple la détection d’un risque immédiat).

- Donner du sens au monde qui nous entoure : par exemple nous utilisons les stéréotypes, généralités et histoires précédentes pour combler le manque d’information lorsque c’est nécessaire et comprendre ainsi l’environnement dans lequel on évolue (ou s’en donner l’impression).

- Agir vite : pour chaque nouvelle information, nous devons évaluer son potentiel d’influence sur la situation, l’appliquer aux décisions que nous allons prendre, imaginer ce qui viendra après et agir en conséquence.

- Mémoriser pour plus tard : nos capacités cognitives sont limitées et nous sommes dans l’incapacité totale de nous souvenir de tout. Nous faisons donc constamment des paris sur ce dont il faut se rappeler et ce qui peut être oublié. Par exemple, nous préférons les généralisations car elles prennent moins de place dans notre mémoire que les spécificités.

Lutter contre nos biais cognitifs ne peut donc pas être aisé puisqu’ils sont intrinsèques à nos modes d’agir.

Ils ressortent de ce que Daniel Kahneman a baptisé le Système 1, c’est-à-dire un fonctionnement du cerveau que nous utilisons (ou qui nous utilise) la plupart du temps, une sorte de pilote automatique qui nous permet d’assurer nos tâches quotidiennes sans trop d’efforts de réflexion : marcher dans la rue, conduire, commander… Nous adaptons instinctivement notre comportement à un contexte donné sans avoir besoin de passer par un raisonnement logique.

Le système 2 au contraire est réfléchi et logique, il se déclenche lorsqu’il est nécessaire de faire un effort intellectuel pour faire sens d’une situation ou d’un problème : effectuer un calcul mathématique, faire le plan d’une dissertation, planifier un évènement, écrire un article pour Réacteur ;)… Un peu comme lorsqu’on demande à notre corps un effort physique qui le sort de sa condition habituelle.

En théorie on pourrait donc penser qu’analyser sérieusement des données factuelles en mode « Système 2 » serait suffisant pour limiter nos biais et que le bon sens et l’honnêteté intellectuelle permettraient à tout un chacun d’arriver aux bonnes conclusions. Mais les choses ne sont pas si simples … Ainsi, en 2014 le psychologue Dan Kahan, de l’Université de Yale a demandé à des Américains s’ils adhéraient à l’idée qu’il existait des preuves solides pour affirmer que le réchauffement climatique est principalement causé par les activités humaines. Leurs réponses ont été mises en relation avec leurs tendances politiques, ainsi qu’avec leur culture scientifique. Plus les électeurs démocrates avaient des connaissances scientifiques élevées, plus ils croyaient à l’impact des activités humaines sur le réchauffement climatique. A l’inverse, plus les électeurs républicains avaient une culture scientifique importante et plus ils étaient climatosceptiques… (https://law.yale.edu/yls-today/news/climate-science-literacy-unrelated-public-acceptance-human-caused-global-warming). Le problème n’est d’ailleurs pas lié qu’aux Républicains, le même Dan Kahan a montré que les Démocrates avaient les mêmes difficultés à accepter le consensus scientifique lorsqu’il s’appliquait à des questions comme le stockage sécurisé des déchets nucléaires ou les effets du port d’armes dissimulé (https://www.tandfonline.com/doi/abs/10.1080/13669877.2010.511246).

On pourrait aussi se dire que s’exposer plus ou moins volontairement aux avis de ses opposants politiques serait un moyen de mieux comprendre leurs points de vue et ainsi de pouvoir entamer un dialogue constructif, mais là encore les choses sont plus compliquées. Ainsi, une équipe de chercheurs en sciences sociales de l’université américaine de Duke a proposé à un large échantillon de républicains et de démocrates utilisant Twitter s’ils voulaient bien suivre pendant un mois un robot Twitter les exposant à des messages produits par des élus, organisations et leaders d’opinion aux idéologies politiques inverses des leurs. Ceux qui ont accepté ont été interrogés à la fin du mois pour mesurer l’effet de cette exposition. Les démocrates n’ont pas montré de changements d’opinion significatif et les républicains en ont été renforcés dans leurs convictions initiales (https://www.pnas.org/content/115/37/9216)…

Un parti pris instinctif en faveur de son propre groupe et de sa vision du monde est profondément ancré dans la psychologie humaine. Et le chercheur d’en conclure que l’appartenance au groupe culturel aurait une influence plus déterminante sur certaines croyances que les connaissances scientifiques elles-mêmes. L’influence des valeurs morales partagées, et en particulier le sentiment de loyauté envers ces valeurs est particulièrement puissant et la « dissonance cognitive » qui s’ensuit nous amène à échafauder toutes sortes de théories pour préserver les valeurs auxquels on tient. Il ne semble donc pas évident de pouvoir se « débiaiser » soi-même mais nous verrons dans l’article du mois prochain que certaines « béquilles », techniques ou mentales, peuvent nous y aider. Bien entendu, elles ne pourront avoir d’intérêt que si nous prenons conscience, et c’était l’objectif de ce premier article, que nous ne sommes naturellement jamais neutres…

Christophe Deschamps, Consultant-formateur : veille stratégique, intelligence économique, social KM, e-réputation, mindmapping, IST (http://www.outilsfroids.net/)

5