De nombreuses études ont été publiées ces dernières années, ayant pour objectif de décoder les critères de pertinence majeurs des moteurs de recherche. Basées sur des sondages auprès de référenceurs ou sur des méthodes de corrélation de type Spearman, leurs résultats parfois fantaisistes montrent les limites des procédés utilisés pour les mener à bien. Les secrets des algorithmes de Google et consorts ne sont pas si faciles à percer et ce type d’étude semble aujourd’hui vain pour mener à bien ce type d’investigation. Mais n’existe-t-il pas d’autres voies plus efficaces ?

Par Philippe Yonnet

Par Philippe YonnetJ’ai participé récemment à la préparation d’une étude SEO sur les critères de référencement réalisé par le Journal du Net. Il s’agissait d’un sondage auprès des personnes inscrites dans l’annuaire professionnel du JDN pour connaître leur opinion sur l’impact de certains facteurs.

Cette étude s’inscrit dans la lignée de nombreuses autres initiatives du même genre lancée depuis une douzaine d’années. Un certain nombre de professionnels du SEO se réfèrent aux résultats de ces travaux pour justifier l’importance de certains critères, ou en minimiser d’autres. Mais que mesurent exactement ces études ? Dans quelle mesure peuvent-elles vraiment donner des informations exploitables d’un point de vue opérationnel ? Nous allons voir qu’il faut garder dans tous les cas la plus grande prudence quant à l’interprétation des résultats ainsi publiés.

La première approche : le sondage

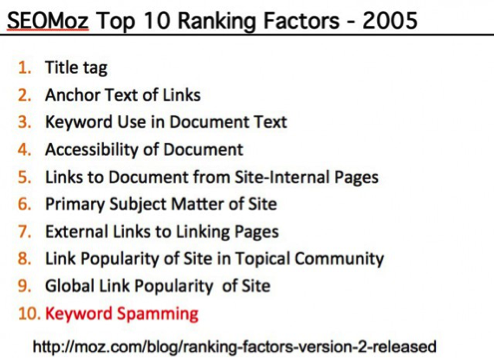

Historiquement, la première étude d’envergure sur les critères de classement dans l’algorithme de Google a été lancée par Rand Fishkin de Moz (à l’époque SEOMoz) en 2005. Cette première initiative a pris la forme d’un sondage auprès d’un échantillon plus que restreint d’experts SEO : 12 personnes…

Cette première édition a été plutôt saluée par les observateurs, même si certains ont critiqué le choix des experts interrogés (notamment la proportion de white hats et de black hats), et le faible nombre de « sondés ».

Fig. 1. Les 10 critères de classement les plus importants d’après le sondage de SEOMoz de 2005.

Une deuxième mouture de l’enquête a été réalisée en 2007, auprès de 35 experts cette fois-ci :

https://moz.com/blog/ranking-factors-version-2-released

Et depuis lors, Moz publie une enquête du même genre tous les deux ans environ. La dernière date de 2015. Le nombre de sondés s’est élargi avec le temps,

Fig. 2. La page de l’étude de MOZ de 2015 : https://moz.com/search-ranking-factors.

Ce type de sondage a fait des émules, y compris dans l’espace francophone. Une première étude a été lancée par Yannick Bouvard en 2015, opération renouvelée en 2016 : http://www.seo-factors.com/

Et plus récemment, cette étude du Journal du Net auprès de 140 référenceurs volontaires :

http://www.journaldunet.com/solutions/seo-referencement/1195455-seo-les-criteres-les-plus-importants-selon-140-referenceurs/

Ce que nous apprennent vraiment les sondages sur les Ranking Factors

Les informations issues des études par sondage sont souvent reprises sans aucune précaution dans la littérature sur le SEO, comme si les « critères » élus comme les plus importants par la majorité des experts en référencement interrogés étaient les plus importants dans l’algorithme de Google.

Phlippe Yonnet

Directeur Général de l’agence Search-Foresight, groupe My Media (http://www.search-foresight.com)