Thomas Cubel propose dans cet article une réflexion sur la notion d’entité, à l’ère de l’intelligence artificielle et surtout de l’apprentissage automatique, domaines dans lesquels vivent de plus en plus des moteurs de recherche comme Google. Comment ce moteur apprend-il de nos contenus, par approches successives, une entité en dévoilant une autre ? Bienvenue dans le monde merveilleux du graphe de connaissances…

En tant qu’acteur s’intéressant au référencement, vous avez sans doute entendu parler du Knowledge Graph (Graphe de connaissance), de Google RankBrain, ou encore des entités nommées. Aussi, vous le savez peut-être, le fait de comprendre la mécanique générale autour de la création, modification et validation des entités est extrêmement important pour pouvoir créer votre site web, imaginer votre graphe de la connaissance et/ou vérifier que ce que vous apportez est correct et complet.

Nous vous proposons dans cet article de prendre du recul sur la notion d’entité, mais aussi de comprendre l’état d’esprit derrière l’une des inventions les plus révolutionnaires qui soient : le graphe de connaissance.

Avertissement : le sujet étant complexe et particulièrement difficile à traiter dans les moindres détails, cet article peut comporter certains raccourcis permettant aux lecteurs de capturer l’essentiel du message. Que les experts du domaine veuillent bien nous en excuser…

Définition et prise de recul sur la notion d’entité

Autour de nous, nous sommes constamment en présence d’objets, de concepts, d’entités. « Une place pour chaque chose et chaque chose à sa place. » disait (d’après Google) un certain Samuel Smiles. Pour étudier le Web, nous devons également prendre conscience de cela : chaque site, chaque page, chaque mot sont des connaissances que l’on peut plus ou moins définir exhaustivement.

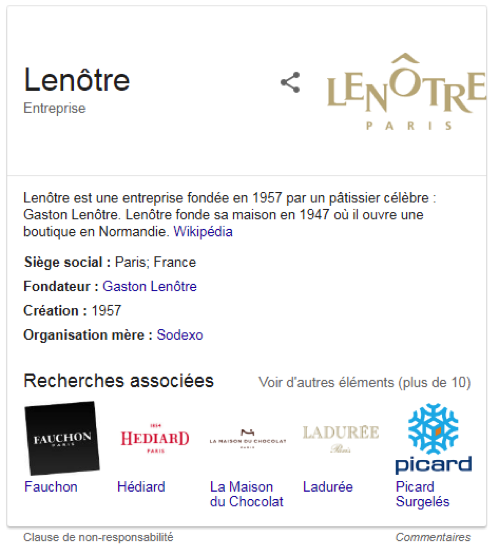

Par exemple, c’est par la citation de nombreux pâtissiers célèbres, de recettes de délicieux gâteaux et de trucs et astuces « de pro », qu’un site de cuisine peut montrer (outre mesure) son expertise dans un domaine spécifique comme la pâtisserie (voir Fig.1).

Fig. 1. Affichage type Knowledge Graph sur Google pour la requête « Lenotre ».

Thomas Cubel, consultant SEO (https://www.thomascubel.com/).