On ne peut bien sûr pas nier l’importance des liens (backlinks) dans une stratégie SEO. Aussi, de nombreux outils (Majestic, Ahrefs, Moz, Sistrix et bientôt Babbar) tentent de reproduire cet écosystème pour founir de la data et des indicateurs quantitatif et qualitatif aux webmasters et référenceurs qui veulent en savoir plus à ce sujet. Tous ces outils se heurtent au quotidien à de nombreux obstacles, tant le paysages des liens est complexe à analyser et à traiter. Voici pourquoi…

Par Sylvain Peyronnet

Par Sylvain Peyronnet

Le SEO n’est plus une discipline si jeune que cela, et depuis qu’elle existe, il existe toujours une forme de consensus sur le fait que l’un des signaux les plus importants pour le moteur de recherche est celui du “profil” de liens d’une page web.

Si ce consensus existe, c’est pour une raison pragmatique d’abord : quand on fait des liens de bonne qualité, on s’aperçoit vite que c’est bon pour monter dans la SERP, mais il existe aussi car Google a bâti toute sa notoriété des premières années sur un algorithme qui détermine l’importance des sites web via l’analyse des liens créés vers les pages desdits sites (“un lien = un vote”). Cet algorithme est bien entendu le PageRank (voir référence [1]).

Une fois n’est pas coutume, nous adopterons dans cet article un point de vue un peu différent de ce que nous faisons d’habitude. En règle générale, on ne parle que de ce que fait le moteur, mais quand on parle de profil de liens, on rentre dans des aspects un peux nébuleux car le moteur ne communique pas trop sur le sujet.

Nous allons donc ici aborder rapidement les critères qualitatifs d’un bon lien, mais très vite, nous allons adopter le point de vue des opérateurs qui fournissent de la data sur les liens, pour que vous compreniez que la tâche est difficile. Difficile ? Oui, à un point qui fait qu’il faut toujours rester vigilant sur les décisions que l’on prend avec la data fournie.

Le bon lien et le mauvais lien, un peu la même histoire que le bon et le mauvais chasseur ?

A la base, un bon lien c’est assez simple : c’est un lien fait sur un site de bonne qualité, par un humain qui pense que le site lié est lui aussi de bonne qualité et apporte une information supplémentaire à celle apportée par l’information contenue dans la page source du lien.

Par ailleurs, quand on a plusieurs bons liens, on peut les trier par importance, c’est-à-dire par popularité de la page qui émet le lien.

Bien entendu, le moteur n’a qu’une vision algorithmique de cette notion de lien bon et important. Dès 1998 l’algorithme du PageRank capte la notion d’importance. Il est intéressant de noter qu’à l’époque, on considère que tous les liens sont bons, et on ne se concentre donc que sur le calcul de l’importance.

Cela nous fait sourire aujourd’hui, mais il ne faut pas oublier que le Web des débuts n’est pas monétisé de manière forcené par les SEOs et donc que la plupart des liens sont faits en toute honnêteté.

Très rapidement, les chercheurs en algorithmique du Web vont se retrouver confrontés à du spam structurel (les fermes de liens, ancêtres des PBN de maintenant, voir référence [2]) faits à partir de sites construits uniquement pour le linking, parfois en récupérant des expirés, qui sont remplis de contenus de mauvaise qualité. Pour pallier tous ces problèmes, un grand nombre d’algorithmes vont être créés, pas tous d’ailleurs déployés par des moteurs de recherche. On trouve notamment parmi ceux-ci le Trustrank, l’anti-trust, la spam mass, la détection de liens népotiques, etc. (voir les références [3] à [8]).

Ensuite, le modèle du PageRank thématique va être mis en place (référence [10]) grâce à Taher Haveliwala, puis la notion de confiance thématique va apparaître (référence [11]). Ces modèles plus évolués ont tous pour but de fournir une vision plus réaliste du comportement des internautes lorsqu’ils suivent les liens entre pages web. Chez Google, la vision va culminer avec la notion de PageRank raisonnable (référence [11]) qui prend en compte l’emplacement des liens pour mieux comprendre le comportement des internautes. Une analyse étant faite a priori pour savoir quel emplacement est réellement important pour les visiteurs.

Enfin, je finirais cet inventaire à la Prévert par la référence [12], qui aborde le sujet de la décote à mettre sur les liens qui pointent vers des ressources qui ont changé. L’objectif de ce type de méthode est de pénaliser le rachat de domaines puissants pour bénéficier d’un boost au démarrage (les stratégies à base d’expirés donc).

La problématique de reconstituer la même information, sans être Google

Il existe de nombreux opérateurs qui se proposent de crawler le Web pour fournir des informations sur les backlinks afin de donner un profil de liens le plus sincère possible, permettant aux SEO d’affiner leur stratégie de visibilité en général, et celle de linking en particulier.

Parmi ceux-ci, on trouve Majestic, Semrush, Sistrix, Moz, Ahrefs, et notre tout nouvel arrivant (“notre” au sens premier, car je suis partie prenante dans son développement) Babbar. Nous allons maintenant voir les points de vigilance qu’il faut avoir concernant ces sources de données, principalement parce que faire comme Google sur l’analyse des liens, c’est difficile !

Crawler le web pour trouver tous les backlinks, à jour

Première source de difficulté : construire un index de backlinks (pas de pages, mais bien de backlinks) qui soit suffisamment exhaustif et représentatif pour qu’une information prise sur ce petit index soit transposable à l’index d’un moteur comme Google.

Par exemple, Majestic dit avoir crawlé 445 milliards d’URLs dans son fresh index, Ahrefs annonce environ 300 milliards d’URL indexées et 30 000 connues, Moz ne communique pas sur le nombre de liens (35 trillions), mais semble avoir un index plus gros que ses deux principaux compétiteurs, etc.

Ces nombres sont impressionnants, et pourtant le SEO qui possède plusieurs outils verra toujours des différences. Si on compare à Google, ils ont des index tout petits, Google annonçant connaître, en 2016, 130 000 milliards d’URL ! (voir référence [13]).

Le facteur limitant pour ces opérateurs est bien entendu l’infrastructure. Fournir de la data à des tiers n’est pas aussi rentable que d’afficher 3 pubs à chaque visiteur, et donc il n’est pas possible d’entretenir une très grosse infrastructure dans ce cas. Un des plus gros, Ahrefs, dit crawler 5 milliards de pages par jour. C’est à la fois beaucoup et peu. Avec ce genre de chiffres il est possible que certains backlinks d’une page apparaissent avec 60 jours de retard.

Un autre point important est celui de la stratégie de crawl. Un site web n’évolue pas dans le vide intergalactique, il est lié à d’autres sites web. Au niveau du profil de liens, il est plus important de connaître le maximum de sites que de connaître moins de sites mais de manière plus exhaustive. C’est contre-intuitif pour les webmasters/SEOs, qui veulent voir apparaître toutes leurs pages dans l’index de l’opérateur, mais en pratique mieux vaut moins de pages, mais une meilleure connaissance des sites “voisins”. C’est un problème majeur pour le crawler, car autant il est facile d’explorer un site complètement, autant il est difficile de “sauter” de sites en sites efficacement. Les moteurs résolvent maintenant ce problème avec de la donnée comportementale (comme la donnée des résolutions DNS, ou celle d’un navigateur comme Chrome) qui n’est pas disponible pour les fournisseurs de data de linking.

Calculer des signaux proches de ceux du moteur : la popularité, la confiance

L’objectif de ces outils est de permettre aux SEO et webmasters de prendre des décisions informées sur leur stratégie de linking. Il faut pour cela fournir des métriques qui soient les plus en phase avec celles du moteur. La plus importante est la notion de popularité dûe au PageRank.

Chez Majestic, on l’appelle CF (Citation Flow), PA (Page Authority) chez Moz, UR (URL Rating) chez Ahrefs, PV (Page Value) chez Babbar, etc.

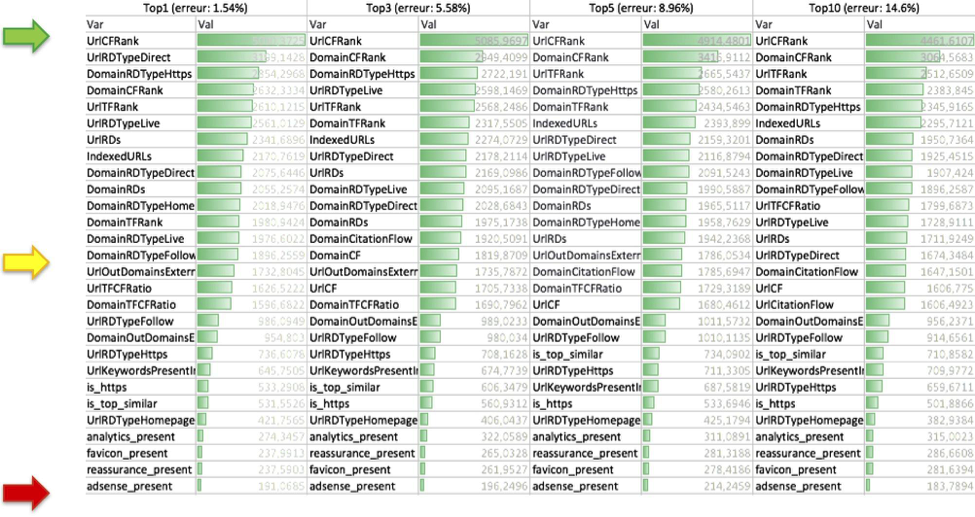

Dans une étude réalisé par Kevin Richard et moi-même en 2018 (référence [14]), nous avons montré le tableau de la figure 1 : on y voit que le CF est un signal important pour le ranking, il remplit donc sa mission d’aider à la décision sur le linking (nous n’avons pas étudié les autres opérateurs à l’époque).

Fig. 1. Facteurs de ranking par K. Richard et S. Peyronnet.

Sur d’autres métriques, les choses ne sont pas si simples. Par exemple, toujours sur Majestic, il est difficile de se prononcer concernant la notion de TF (Trust Flow). En premier lieu parce que le CF et le TF sont très corrélés et il n’y a donc pas forcément d’effet autre que celui lié au CF lorsqu’il y a un fort TF. D’autre part, la méthode de calcul en partant de sites sourcés à la main pour le niveau de confiance important qu’on leur donne a un biais : elle donne de la confiance comme il faut à beaucoup de sites, mais laisse des “trous dans la raquette” sur les thématiques où il n’y a pas de sites évidents comme sources de confiance. Aujourd’hui il n’existe objectivement pas d’opérateurs de confiance sur la notion de confiance 😉

Voir le web comme le moteur le voit : la notion de thématique

Depuis quelques années, tout le monde a bien compris que le moteur voit et utilise la thématique portée par une page pour moduler le transport de popularité. La notion de PageRank thématique de Taher Haveliwala, très probablement mise en route chez Google lors de l’update Caffeine, permet de donner une popularité différente à chaque page selon la thématique de la requête tapée par l’utilisateur du moteur.

Pour les fournisseurs de données de linking, fournir une information de thématisation des pages semblent cruciale. Et le moins qu’on puisse dire est que pour l’instant, il n’existe absolument rien de satisfaisant.

Premier constat : une page a une ou plusieurs thématiques qui dépendent uniquement de son contenu. Le seul moyen de déterminer cette thématique est d’analyser à la main ou via un algorithme de classification le contenu de la page. Deuxième constat : un lien possède un facteur d’amortissement de transmission de popularité qui dépend de l’adéquation thématique entre la page source et la page cible.

Très concrètement, cela veut dire qu’un lien entre deux pages parlant de voitures va avoir un coefficient d’amortissement nul (100% de la popularité se transmet), alors qu’une page parlant de voitures vers une page parlant de camions (exemple non contractuel, bien entendu) ne transmettra que 80% de sa popularité.

Cela amène à un quiproquo commun chez les SEO qui utilisent, par exemple, Majestic. Quand on décide de faire un lien vers son site (thématique voiture par exemple), prendre ses liens depuis des sites “voitures” veut dire que la valeur de CF faciale du site source est correcte pour prendre sa décision. Si on est sur une thématique plus éloignée, le lien a toujours de la valeur, mais avec un facteur d’amortissement. Cela veut dire qu’un lien très puissant non thématisé est peut être plus intéressant qu’un lien très peu puissant thématisé, cela se regarde au cas par cas en l’absence de métrique fiable fournie par les opérateurs sur ce point.

Autre point corollaire : si vous analysez une page qui parle de voiture, mais que Majestic vous attribue la thématique “ordinateur”, cela veut dire que votre popularité annoncée par l’outil est largement surévaluée. En effet, l’outil fait de la transmission de thématique, une notion qui n’existe pas au niveau d’un moteur de recherche.

Voir le web comme le moteur le voit : le spam

Sur cet aspect, il ne faut pas trop raconter d’histoires : aujourd’hui, seuls les moteurs luttent contre le spam de manière algorithmique réelle. Pour le reste, les SEO bricolent avec le mystique ratio CF versus TF ou son analogue chez les concurrents.

On voit aussi qu’un certains nombre de liens ne sont pas “vus” par les opérateurs, tout simplement car les domaines qui les émettent sont blacklistés à la main.

Bref, sur ce plan tout est à faire, et n’est pas pour demain. Pourquoi ? Parce que le coût calculatoire de ces algorithmes est trop haut et que si un opérateur de vente de données savaient le faire efficacement, il aurait plutôt intérêt à devenir un moteur de recherche.

Voir le web comme le moteur le voit : le comportement et l’intention

Les toutes dernières modifications de Google sont très impressionnantes avec la mise en place d’algorithmes de machine learning très en pointe comme BERT (voir notre précédent article dans Réacteur le mois dernier) qui permettent de comprendre l’intention réelle des utilisateurs du moteur.

Il y a tout à parier que la prochaine modification de l’algorithme du PageRank prendra en compte les vecteurs encodant les contenus des pages pour moduler la transmission de popularité.

Dans cette optique, un lien “machine à café “ vers “frigidaire-congélateur” aura un amortissement très fort, un lien “machine à café” vers “machine à café” aura une bonne transmission, mais l’intention rentrera dans la partie, l’amortissement sera donc différent entre un lien “acheter machine à café” vers “machine à café pas chère” et un lien “détartrer machine à café” vers “machine à café pas chère”. Une distinction qui permettra de faire coller les métriques de popularité chères aux SEO vers des métriques captant également la notion de continuité de conversion, permettant ainsi de réconcilier définitivement les SEO et les webmarketeurs !

OK, j’en fais quoi de tout ça ?

Le propos de cet article est de se rendre compte que la data des opérateurs d’analyse de backlinks est une data complexe à rassembler et complexe à résumer par des métriques fiables. Le SEO, être humain avant tout, doit faire confiance à son jugement personnel dans un très grand nombre de cas, même si de plus en plus les outils progressent et offrent des métriques aidant réellement l’arbitrage humain.

Références

[1] Page, L., Brin, S., Motwani, R., & Winograd, T. (1999). The PageRank citation ranking: Bringing order to the web. Stanford InfoLab.

http://ilpubs.stanford.edu:8090/422/1/1999-66.pdf

[2] Gyöngyi, Z., & Garcia-Molina, H. (2005, August). Link spam alliances. In Proceedings of the 31st international conference on Very large data bases (pp. 517-528). VLDB Endowment.

http://ilpubs.stanford.edu:8090/679/1/2005-15.pdf

[3] Wu, B., & Davison, B. D. (2005, May). Identifying link farm spam pages. In Special interest tracks and posters of the 14th international conference on World Wide Web (pp. 820-829). ACM.

http://www.ra.ethz.ch/CDstore/www2005/docs/p820.pdf

[4] Becchetti, L., Castillo, C., Donato, D., Leonardi, S., & Baeza-Yates, R. A. (2006, August). Link-based characterization and detection of web spam. In AIRWeb (pp. 1-8).

http://ra.ethz.ch/CDstore/www2008/airweb.cse.lehigh.edu/2006/proceedings.pdf#page=45

[5] Krishnan, V., & Raj, R. (2006, August). Web spam detection with anti-trust rank. In AIRWeb (Vol. 6, pp. 37-40).

[6] Gyöngyi, Z., Garcia-Molina, H., & Pedersen, J. (2004, August). Combating web spam with trustrank. In Proceedings of the Thirtieth international conference on Very large data bases-Volume 30 (pp. 576-587). VLDB Endowment.

http://ilpubs.stanford.edu:8090/770/1/2004-52.pdf

[7] Gyongyi, Z., Berkhin, P., Garcia-Molina, H., & Pedersen, J. (2006, September). Link spam detection based on mass estimation. In Proceedings of the 32nd international conference on Very large data bases (pp. 439-450). VLDB Endowment.

[8] Davison, B. D. (2000). Recognizing nepotistic links on the web. Artificial Intelligence for Web Search, 23-28.

https://www.aaai.org/Papers/Workshops/2000/WS-00-01/WS00-01-005.pdf

[9] Haveliwala, T. H. (2003). Topic-sensitive pagerank: A context-sensitive ranking algorithm for web search. IEEE transactions on knowledge and data engineering, 15(4), 784-796.

http://ilpubs.stanford.edu:8090/750/1/2003-29.pdf

[10] Wu, B., Goel, V., & Davison, B. D. (2006, May). Topical trustrank: Using topicality to combat web spam. In Proceedings of the 15th international conference on World Wide Web (pp. 63-72). ACM.

http://wwwconference.org/www2006/programme/files/pdf/3115.pdf

[11] Dean, J. A., Anderson, C., & Battle, A. (2018). U.S. Patent Application No. 10/152,520.

[12] Dai, N., & Davison, B. D. (2009, November). Vetting the links of the web. In Proceedings of the 18th ACM conference on Information and knowledge management (pp. 1745-1748). ACM.

http://wbox0.cse.lehigh.edu/~brian/pubs/2009/CIKM/vetting.pdf

[13] https://www.seroundtable.com/google-130-trillion-pages-22985.html

[14] https://fr.slideshare.net/512banque/les-serps-ont-parl-comment-font-ceux-qui-performent-en-2018

Sylvain Peyronnet, fondateur de la régie publicitaire sans tracking The Machine In The Middle (http://themachineinthemiddle.fr/).

5