Depuis sa naissance, le métier du SEO est indissociablement lié à toutes sortes d’investigations, de tests et de recherches. On peut même dire que la remise en question, la volonté de tester, d’étudier, de casser les légendes urbaines font partie de l’ADN de toute personne qui fait du SEO. Encore faut-il le faire intelligemment et dans les règles de l’art, comme certains exemple malheureux nous l’ont montré par le passé…

Depuis sa naissance, le métier du SEO est indissociablement lié à toutes sortes d’investigations, de tests et de recherches. On peut même dire que la remise en question, la volonté de tester, d’étudier, de casser les légendes urbaines font partie de l’ADN de toute personne qui fait du SEO. Encore faut-il le faire intelligemment et dans les règles de l’art, comme certains exemple malheureux nous l’ont montré par le passé…

Cette série de deux articles est une version textuelle de la conférence de l’auteur au SEOCamp’us Paris tenue le 24 septembre 2021. Dans ce premier article, on abordera de différents aspects de recherches SEO notamment les types d’investigations, la mise en place correcte des études, méthodologies, ainsi que divers biais qui peuvent facilement ruiner tout le travail et quelques aspects éthiques.

Dans la seconde partie, nous verrons comment les choses se mettent en place en pratique sur une sélection de 5 tests et études réels et concrets.

Il était une fois en 2016…

Pour commencer, revenons 5 ans en arrière…

Nous étions en 2016, une année riche en événements : Coupe d’Europe de football en France, Donald Trump élu président des Etats-Unis … Mais une des actualités qui a probablement le plus marqué le monde du digital était le lancement de Google Assistant par le géant de Mountain View.

L’engouement vers ces nouvelles technologies vocales était d’une ampleur impressionnante : on apprenait à interagir avec les nouveaux outils et terminaux en leur envoyant des commandes et les bombardant de questions (évidemment intelligentes).

Et naturellement, on se posait des questions sur l’avenir de ces nouveaux appareils et sur leur influence future au niveau de nos comportements digitaux. Mais ni Google, ni Amazon ne se dépêchaient de partager leurs chiffres et projections.

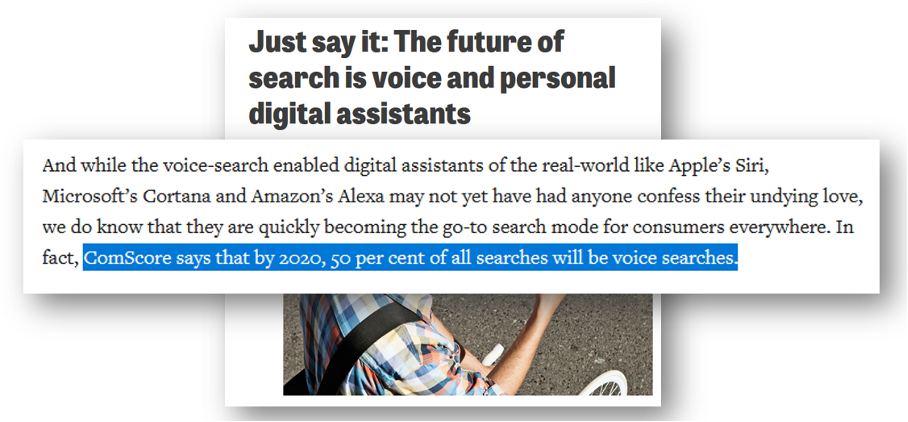

Et voici que le 25 avril 2016 le magazine britannique Campaignlive.co.uk publie l’article « Just say it: The future of search is voice and personal digital assistants » citant les résultats de l’étude d’une entreprise américaine qui postulait que « vers 2020 50% de toutes les recherches seront vocales ».

Extrait de l’article « Just say it: The future of search is voice and personal digital assistants » avec la fameuse prédiction.

Source : https://www.campaignlive.co.uk/article/just-say-it-future-search-voice-personal-digital-assistants/1392459

Cet article a eu un énorme succès. Il a été relayé par Forbes, Inc., Entrepreneur, Deloitte, Search Engine Journal et bien d’autres. Selon les données de MajesticSEO, la page de l’article reçoit des liens depuis plus de 2 000 sites tiers, et ce ne sont pas n’importe quels sites !

Ces chiffres « 50% en 2020 » sont devenus une partie intégrante de toutes les conférences, appels d’offre, audits SEO, là où on décelait la moindre mention de la recherche vocale.

En voilà qu’on arrivait en 2020 et qu’on commençait à se poser une question bien plus que logique : « Et concernant cette projection, on en est où aujourd’hui ? ».

Depuis sa naissance, le métier du SEO est indissociablement lié à toutes sortes d’investigations, de tests et de recherches. On peut même dire que la remise en question, la volonté de tester, d’étudier, de casser les légendes urbaines font partie de l’ADN de toute personne qui fait du SEO. Encore faut-il le faire intelligemment et dans les règles de l’art, comme certains exemple malheureux nous l’ont montré par le passé…

Depuis sa naissance, le métier du SEO est indissociablement lié à toutes sortes d’investigations, de tests et de recherches. On peut même dire que la remise en question, la volonté de tester, d’étudier, de casser les légendes urbaines font partie de l’ADN de toute personne qui fait du SEO. Encore faut-il le faire intelligemment et dans les règles de l’art, comme certains exemple malheureux nous l’ont montré par le passé…

5